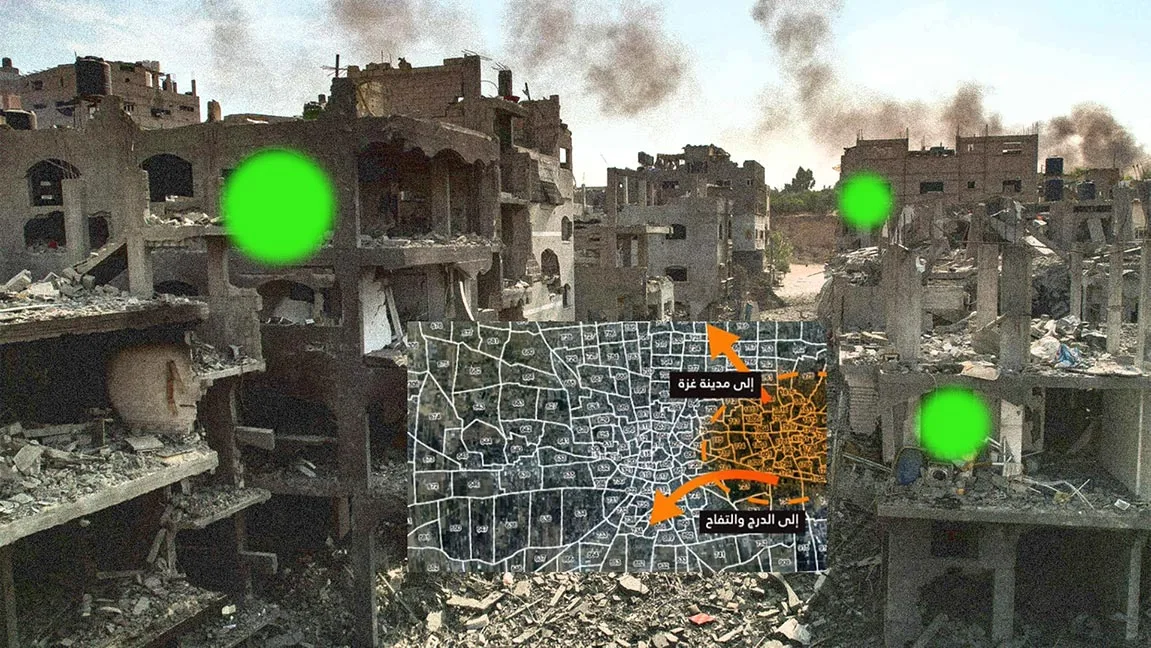

هوش مصنوعی (AI) به موضوعی نگران کننده تبدیل شده است زیرا کشورهایی مانند ایالات متحده و چین آن را در عملیات نظامی خود گنجاندهاند. اخیراً گزارشهایی منتشر شد مبنی بر اینکه اسرائیل از فناوری هوش مصنوعی برای شناسایی اهداف بمباران غزه استفاده میکند که نگرانیهای عمیقی را در مورد ایمنی غیرنظامیان و خطوط مبهم مسئولیتپذیری ایجاد میکند.

به گفته مجله 972+ و تماسهای محلی مستقر در تل آویو، اسرائیل از یک برنامه هوش مصنوعی به نام “Lavender” برای ایجاد اهداف ترور، بهویژه فلسطینیهایی که مظنون به شبه نظامیان حماس هستند، استفاده میکرد. این گزارش ادعا میکند که این سیستم هوش مصنوعی نقش مهمی در کمپین بمباران بیسابقه علیه فلسطینیها ایفا کرده است.

آنتونیو گوترش، دبیر کل سازمان ملل متحد، از استفاده از هوش مصنوعی به این شیوه ابراز ناراحتی کرد. او استدلال کرد که تصمیمات مرگ و زندگی که بر کل خانواده ها تأثیر میگذارد، نباید به الگوریتمها واگذار شود. گوترش تاکید کرد که هوش مصنوعی باید به جای کمک به تشدید جنگ و کاهش پاسخگویی، نیرویی برای خیر باشد و به نفع جهان باشد.

بیشتر بخوانید: جنگ اسرائیل و فلسطین برای شرکتهای فناوری منطقه چه معنایی دارد

مقاله یووال آبراهام در مجله 972+ به نقل از افسران اطلاعاتی اسرائیلی میپردازد که مستقیماً با استفاده از هوش مصنوعی برای ایجاد اهداف برای ترور مشارکت داشتند. این افسران فاش کردند که تأثیر برنامه هوش مصنوعی Lavender بهقدری قابل توجه بود که با خروجیهای آن به گونهای برخورد میشد که گویی تصمیمات انسانی است. لیستهای کشتار نرمافزاری توسط افسران تأیید شده و فقط توسط نیروی انسانی «مهر تایید» میخورد، علیرغم اذعان به اینکه سیستم تقریباً در 10 درصد موارد خطا داشته و گهگاه افرادی را هدف قرار میدهد که هیچ ارتباطی با گروههای شبهنظامی ندارند.

منابع آبراهام تاکید کردند که هزاران فلسطینی، که بسیاری از آنها غیرنظامیان بیگناه از جمله زنان و کودکان بودند، در حملات هوایی اسرائیل در مراحل اولیه جنگ به دلیل تصمیمات اتخاذ شده توسط برنامه هوش مصنوعی کشته شدند. طبق گزارش ها، لاوندر حدود 37.000 ستیزه جوی حماس را برای ترور انتخاب کرد که عمدتاً از اعضای جوانتر بودند.

استفاده از هوش مصنوعی در جنگ سوالات اخلاقی جدی را مطرح میکند و اصول حقوق بین الملل را به چالش میکشد. مجمع عمومی سازمان ملل متحد اخیرا قطعنامهای غیرالزامآور را با هدف ارتقای توسعه سیستمهای هوش مصنوعی ایمن و قابل اعتماد تصویب کرد. با این حال، این قطعنامه که توسط بیش از 110 کشور از جمله چین حمایت شده است، استفاده نظامی از هوش مصنوعی را مورد توجه قرار نداده است.

نیروهای دفاعی اسرائیل (IDF) استفاده از هوش مصنوعی در شناسایی اهداف را رد میکند و ادعا میکند که سیستمهای اطلاعاتی آنها صرفاً ابزارهایی هستند که توسط تحلیلگران در فرآیند شناسایی هدف استفاده میشوند. ارتش اسرائیل مدعی است که تحلیلگران ملزم به انجام آزمایشات مستقل هستند تا اطمینان حاصل شود که اهداف شناسایی شده مطابق با تعاریف مربوطه مطابق با قوانین بین المللی و دستورالعملهای اسرائیل هستند.

در حالی که جزئیات این پرونده هنوز مورد بحث است، گفتگوی گستردهتر در مورد استفاده نظامی از هوش مصنوعی مستلزم بررسی دقیق است. سنجیدن مزایای بالقوه هوش مصنوعی در افزایش قابلیتهای نظامی در مقابل خطراتی که برای ایمنی غیرنظامیان، پاسخگویی و پایبندی به قوانین و هنجارهای بین المللی ایجاد میکند، بسیار مهم است.